推 gameguy: A6000 ads不用謝我114.136.255.153 10/13 10:54

推 sachialanlus: 建議試試看用 ollama + ainiee 來翻111.248.203.51 10/13 11:06

→ sachialanlus: 譯, 不要用 sakurallm 自己的 back111.248.203.51 10/13 11:06

→ sachialanlus: end。111.248.203.51 10/13 11:06

→ sachialanlus: 如果是 llama.cpp 的話記得把 promp111.248.203.51 10/13 11:06

→ sachialanlus: t_cache 打開,不用每次都重跑 syst111.248.203.51 10/13 11:06

→ sachialanlus: em prompt。111.248.203.51 10/13 11:06

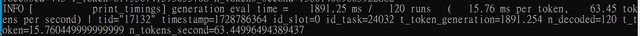

→ sachialanlus: 另外 inference 完全是 memory boun111.248.203.51 10/13 11:06

→ sachialanlus: d,可以直接按照 vram bandwidth 來111.248.203.51 10/13 11:06

→ sachialanlus: 選卡即可,速度基本上就是 "模型大111.248.203.51 10/13 11:06

→ sachialanlus: 小/頻寬" = n token/s。111.248.203.51 10/13 11:06

→ sachialanlus: 啊對了 sakurallm 14b 出 v1.0 的模111.248.203.51 10/13 11:08

→ sachialanlus: 型了111.248.203.51 10/13 11:08

→ hHolic: AI應用 瓶頸都在VRAM 吞吐跟不上運算118.232.28.161 10/13 11:26

→ sachialanlus: 輸入的部分 也就是 prompt eval 和111.248.203.51 10/13 11:27

→ sachialanlus: 算力有關 而生成的部分 token gener111.248.203.51 10/13 11:27

→ sachialanlus: ation 則和 memory bandwidth 有關111.248.203.51 10/13 11:27

→ sachialanlus: 主因是現在顯卡的算力遠大於頻寬 通111.248.203.51 10/13 11:27

→ sachialanlus: 常瓶頸都是卡在 token generation 111.248.203.51 10/13 11:27

→ sachialanlus: 現在出的很多加速手段底層原理都有 111.248.203.51 10/13 11:31

→ sachialanlus: 用到 recompute 就是寧願重新計算也 111.248.203.51 10/13 11:31

→ sachialanlus: 要省 vram 傳輸量 藉此來提高速度 111.248.203.51 10/13 11:31

推 chang1248w: 長見識 140.115.212.91 10/13 11:57

推 sxing6326: 4張V100 223.139.216.85 10/13 12:21

推 yesheyman: 請問rocm是指6.2最新那版? 70.95.16.251 10/13 12:30

推 jhjhs33504: 至少挑Qwen2.5或llama3.1之後比較聰明 104.28.156.246 10/13 14:16

推 jhjhs33504: 之前的必須進行一番提示工程才達能用 104.28.156.246 10/13 14:20

推 jhjhs33504: 借串問一下UALink有下文嗎? 104.28.156.246 10/13 14:22

→ soulgem: 14b 用 16G VRAM 真的可以跑嗎? 140.112.30.188 10/13 14:44

→ soulgem: 印象中不見得就是 1:1, 可能要實驗... 140.112.30.188 10/13 14:45

→ soulgem: 7900XTX 是 24G VRAM... 140.112.30.188 10/13 14:45

推 YukilinnMigu: 買兩張3090 nvlink 101.8.46.184 10/13 14:55

→ sachialanlus: sakurallm 14b 只有釋出 iq4 的量化 111.248.203.51 10/13 15:07

→ sachialanlus: 版本 大概要 9G 左右的 vram 111.248.203.51 10/13 15:07

推 chang1248w: 跑半精度吧 42.72.182.147 10/13 15:44

→ chang1248w: 這麼狠 42.72.182.147 10/13 15:45

→ dogluckyno1: 4070 TiS 呢? 106.64.97.240 10/13 15:54

推 speed7022: 這個東西翻譯出來的效果怎麼樣? 223.137.239.51 10/13 16:59

→ sachialanlus: 我自己使用下來效果感覺滿好的 至少 111.248.203.51 10/13 17:17

→ sachialanlus: 已經是能用的地步了 但人名還是不可 111.248.203.51 10/13 17:17

→ sachialanlus: 避免的會有不同翻譯的問題 111.248.203.51 10/13 17:17

推 yymeow: 不就主要看VRAM有多大,再來就看有沒有會 114.25.210.39 10/13 17:32

→ yymeow: 使用到CUDA,這兩個條件來決定 114.25.210.39 10/13 17:33

推 march55237: 有預算直上二手3090 125.229.194.48 10/13 19:07

推 CLisOM: 看過sakura翻譯小說,優點是輕小說特化所 220.141.5.220 10/13 22:47

→ CLisOM: 以相關奇幻異世界字彙甚至比出版社菜鳥翻 220.141.5.220 10/13 22:47

→ CLisOM: 的好,文筆流暢,問題是人名如果是假名拼 220.141.5.220 10/13 22:47

→ CLisOM: 音可能會一段文章翻成三個不同人名,男角 220.141.5.220 10/13 22:47

→ CLisOM: 稱呼常常用她,然後句子省略的主詞人名會 220.141.5.220 10/13 22:47

→ CLisOM: 亂猜 220.141.5.220 10/13 22:47

推 AmigoSin: 買NV的還有機會用QLoRA微調 111.250.192.15 10/14 00:28

推 Ghosts: N卡裝VLLM走非同步request可以很快 36.228.231.44 10/14 00:58

→ Ghosts: 不過A卡沒試過,也許也有效果 36.228.231.44 10/14 00:58

→ mtc5566: ROCm如果速度不錯就上78XT阿 支持一下AMD 39.15.24.39 10/14 01:50

推 jhjhs33504: 有需要用到Nsight? 104.28.156.244 10/14 02:35

推 et1783: 人名可以辭典化了,也能根據詞頻去過濾, 122.118.44.203 10/14 16:09

→ et1783: 方便快速抓取定義 122.118.44.203 10/14 16:09

→ jakevin: a-14B-Qwen2.5-v1.0-GGUF152.165.138.182 10/14 21:53

→ jakevin: SakuraLLM/Sakura-14B-Qwen2.5-v1.0-GGUF152.165.138.182 10/14 21:53

→ jakevin: 最新是這個吧,看起來有支援字典功能152.165.138.182 10/14 21:54

推 neo5277: 14b我是4070ti14g,128gi713700k順跑 111.243.95.73 10/15 01:37

推 moonlightz: 咦 4070TI有出14G的規格? 223.141.148.10 10/15 08:21